La promesa de la arquitectura Serverless es seductora: pagas solo por lo que usas y escalas al infinito. Pero hay una letra pequeña que, si se ignora, puede arruinar la experiencia de usuario: los Cold Starts (Arranques en Frío).

Imagina que un usuario hace clic en “Pagar” en tu app y el sistema se queda “pensando” durante 3 o 5 segundos. En el mundo digital de hoy, eso es una eternidad.

En Tijiki, optimizamos aplicaciones serverless diariamente. Hoy te explicamos técnicamente por qué sucede este fenómeno y, lo más importante, cómo solucionarlo.

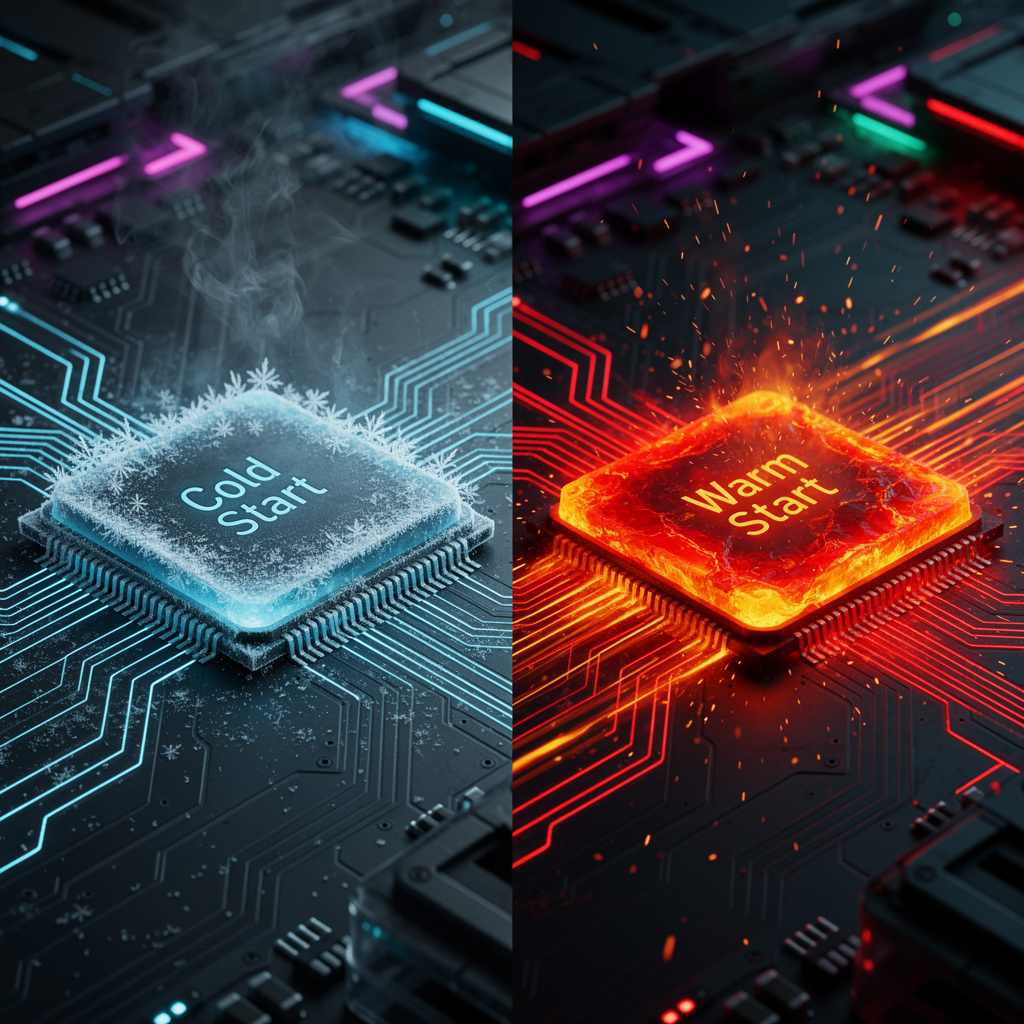

¿Qué es exactamente un Cold Start?

AWS Lambda no mantiene tu código ejecutándose permanentemente en un servidor (eso sería un servidor tradicional). Cuando nadie usa tu función, AWS “apaga” el entorno para ahorrar recursos.

Cuando llega una nueva petición después de un tiempo de inactividad, AWS debe realizar una serie de pasos antes de poder ejecutar tu código:

- Descargar tu código de S3.

- Crear un nuevo contenedor (microVM).

- Iniciar el entorno de ejecución (Runtime startup).

- Inicializar tu código (declaración de variables globales, conexiones a BD).

Todo este proceso previo es el Cold Start. Puede durar desde unos pocos milisegundos hasta varios segundos, dependiendo de la complejidad.

Una vez que la función ha corrido, el contenedor se queda “caliente” (Warm) por un tiempo indeterminado (usualmente entre 5 y 15 minutos). Si llega otra petición en ese lapso, la respuesta es inmediata.

¿Cómo evitar o mitigar los Cold Starts?

No siempre puedes eliminarlos al 100%, pero puedes reducirlos drásticamente con estas estrategias.

1. Provisioned Concurrency (La Solución Premium)

Si el rendimiento es crítico y el presupuesto lo permite, esta es la solución oficial de AWS.

¿Cómo funciona? Le dices a AWS: “Mantén siempre 10 instancias de esta función listas y calientes”. AWS se salta la fase de inicialización. Cuando llega el tráfico, las funciones responden en milisegundos.

- Pros: Latencia cero garantizada.

- Contras: Cuesta dinero (pagas por hora, uses o no la función), rompiendo un poco la filosofía “pay-per-use” pura.

2. El “Ping” Periódico (La Estrategia Casera)

Es el truco más viejo del libro, pero sigue siendo útil para proyectos con presupuesto ajustado.

¿Cómo funciona?

Configuras una regla de EventBridge (antes CloudWatch Events) para que invoque tu función Lambda cada 5 o 10 minutos con un payload “dummy” (ej. { "type": "keep-alive" }). Esto evita que AWS “congele” el contenedor.

- Pros: Muy barato y fácil de implementar.

- Contras: Solo mantiene caliente una instancia. Si tienes un pico de tráfico concurrente (ej. 50 usuarios a la vez), 49 de ellos sufrirán un Cold Start.

3. Optimización del Código y Dependencias

El tamaño importa. Cuanto más pesado sea tu paquete de despliegue, más tarda AWS en descargarlo y descomprimirlo.

- Tree Shaking: Usa herramientas como Webpack o Esbuild para eliminar código muerto.

- Imports Selectivos: No importes todo el SDK de AWS (

const AWS = require('aws-sdk')) si solo vas a usar DynamoDB. Importa solo el cliente necesario. - Reutilización de Conexiones: Asegúrate de declarar tus conexiones a base de datos fuera del

handlerde la función para que se reutilicen en invocaciones subsiguientes.

4. Elegir el Runtime Adecuado

No todos los lenguajes nacen iguales en el mundo Serverless.

- Los Rápidos: Node.js, Python y Go tienen tiempos de arranque muy rápidos debido a su naturaleza ligera.

- Los Pesados: Java y .NET suelen tener Cold Starts más largos debido a la carga de la JVM o el CLR.

- Nota: Para Java, AWS lanzó Lambda SnapStart, que mejora esto significativamente tomando una “foto” de la memoria inicializada.

Conclusión

Los Cold Starts son una realidad de la arquitectura Serverless, pero no deben ser un impedimento. Para procesos en segundo plano (background jobs), no importan. Para APIs de cara al usuario, debes gestionarlos.

La clave está en encontrar el equilibrio entre el costo (Provisioned Concurrency) y la optimización técnica.

¿Tu aplicación en la nube se siente lenta o costosa? En Tijiki, auditamos y optimizamos arquitecturas Serverless para lograr el máximo rendimiento al menor costo posible. Hablemos de cómo acelerar tu software.